L'intelligenza artificiale spiega le immagini AI

Nelle pagine precedenti ho mostrato alcuni esperimenti con le immagini generate da modelli di intelligenza artificiale.

Qui riporto una intervista a ChatGPT (Nuova pagina), che ci parla di generazione di immagini text-to-image.

Chat GPT, per chi ancora non lo sapesse, è è un programma basato su intelligenza artificiale e machine learning (apprendimento automatico) sviluppato da OpenAI specializzato nella conversazione con un utente umano. Può interagire in numerose lingue, tra cui l'italiano, e fornisce risposte alle varie domande che vengono poste.

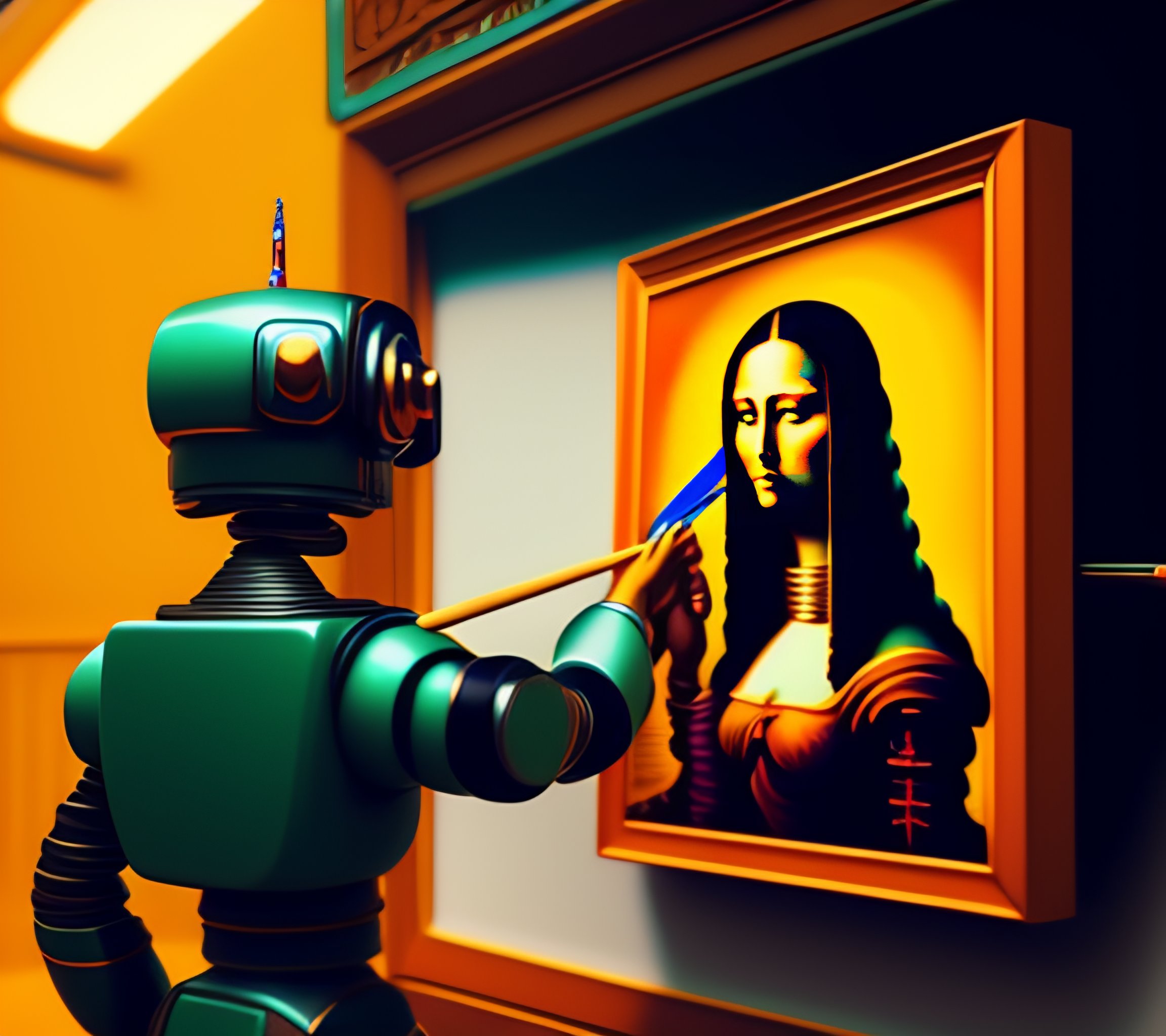

Le immagini a corredo sono state recuperate con il motore di ricerca di Lexica (Nuova pagina), già presentato in un'altra storia. Nelle didascalie è riportato il prompt con il quale le immagini sono state generate.

Ciao

Ciao! Come posso aiutarti oggi?

Sono un appassionato di fotografia ed ho fatto alcuni esperimenti con la generazione di immagini text2image, mi piacerebbe sapere qualcosa di più.

La generazione di immagini text-to-image (T2I) è un campo di ricerca che mira a generare immagini realistiche da descrizioni testuali. Questo tipo di tecnologia si basa sull'uso di reti neurali artificiali, in particolare sulle GAN (Generative Adversarial Networks), che sono in grado di apprendere a generare immagini realistiche a partire da descrizioni testuali.

Ci sono molti approcci diversi alla generazione di immagini T2I, ma in generale l'obiettivo principale è quello di far sì che il modello di generazione impari a rappresentare le descrizioni testuali in un formato che possa essere utilizzato per generare un'immagine realistica. Questo può essere fatto addestrando il modello su un grande corpus di immagini e descrizioni testuali, in modo da far sì che il modello impari a "tradurre" le descrizioni testuali in immagini realistiche.

Ci sono diverse librerie e framework che ti permettono di creare modelli di generazione T2I. Ad esempio, TensorFlow, PyTorch e Keras offrono molte funzionalità per creare modelli di questo tipo.

Se vuoi saperne di più sulla generazione di immagini T2I, ti consiglio di leggere alcuni dei lavori di ricerca più recenti su questo argomento, come "Generative Adversarial Text-to-Image Synthesis" di Reed et al. (2016), "StackGAN: Text to Photo-realistic Image Synthesis with Stacked Generative Adversarial Networks" di Zhang et al. (2017), e "AttnGAN: Fine-Grained Text to Image Generation with Attentional Generative Adversarial Networks" di Xu et al. (2018).

Interessante, io ho utilizzato Stable Diffusion (Nuova pagina)

Stable Diffusion è un algoritmo di generazione di immagini recente che utilizza una tecnica di diffusione stabilizzata per generare immagini di alta qualità. L'algoritmo si basa sull'idea di diffondere un'immagine a partire da un rumore casuale attraverso una serie di passaggi di diffusione, ognuno dei quali "fissa" gradualmente l'immagine in modo che diventi sempre più nitida.

La tecnica di diffusione stabilizzata utilizzata da Stable Diffusion aiuta a migliorare la qualità delle immagini generate riducendo l'instabilità che può verificarsi durante il processo di generazione. Inoltre, Stable Diffusion è in grado di generare immagini ad alta risoluzione (fino a 1024x1024 pixel) con una buona fedeltà ai dettagli dell'immagine originale.

Stable Diffusion è stato utilizzato con successo in molti progetti di ricerca e di creazione artistica. Inoltre, il codice sorgente di Stable Diffusion è disponibile pubblicamente su GitHub, il che lo rende facilmente accessibile e utilizzabile da parte della comunità di sviluppatori.

Se vuoi approfondire la tua conoscenza di Stable Diffusion e della sua applicazione alla generazione di immagini, ti consiglio di esplorare i lavori di ricerca più recenti su questo algoritmo e di dare un'occhiata al codice sorgente disponibile su GitHub.

In quale linguaggio è scritto il codice?

Il codice sorgente di Stable Diffusion è scritto in Python utilizzando la libreria PyTorch. PyTorch è un framework di deep learning open source che offre molte funzionalità per la creazione di modelli di deep learning, compresi quelli per la generazione di immagini. PyTorch è stato scelto come piattaforma per Stable Diffusion perché è altamente flessibile e modulare, il che lo rende adatto alla creazione di algoritmi di deep learning avanzati come questo.

Inoltre, PyTorch offre una serie di strumenti per la gestione dei tensori e delle operazioni di algebra lineare che sono necessarie per implementare i modelli di deep learning. Questi strumenti rendono più semplice e efficiente l'implementazione di modelli di deep learning complessi come Stable Diffusion.

Infine, Python è un linguaggio di programmazione molto popolare e facile da imparare, che ha una vasta comunità di sviluppatori e molti pacchetti di terze parti disponibili. Questo rende più facile per i programmatori lavorare con il codice di Stable Diffusion e personalizzarlo per le proprie esigenze

Ho delle piccole conoscenze di Python, potrebbe essere una occasione per approfondire

Assolutamente! Python è un linguaggio di programmazione molto popolare ed è ampiamente utilizzato nel campo del machine learning e del deep learning. Se sei interessato alla generazione di immagini e vuoi approfondire le tue conoscenze di Python, ci sono molti modi per farlo.

Innanzitutto, puoi iniziare con i tutorial online e con la documentazione ufficiale di Python. Questi risorse ti forniranno una buona base di conoscenze per iniziare a lavorare con Python.

Successivamente, puoi esplorare i tutorial online e le risorse sulla generazione di immagini in Python utilizzando PyTorch o altri framework di deep learning come TensorFlow e Keras. Questi tutorial ti aiuteranno a comprendere meglio i concetti di deep learning e la generazione di immagini.

Infine, puoi partecipare a corsi online o offline sul machine learning e il deep learning in Python. Ci sono molti corsi disponibili, a vari livelli di difficoltà, che ti forniranno una formazione approfondita sui concetti di machine learning e sulle tecniche di generazione di immagini.

In generale, l'apprendimento di Python e delle tecniche di generazione di immagini richiederà impegno e pratica, ma sono sicuro che potrai farlo!

Bene, proverò

Ottimo, sono contento di sentire che vuoi approfondire le tue conoscenze di Python e delle tecniche di generazione di immagini. Non esitare a contattarmi se hai domande o dubbi durante il tuo percorso di apprendimento. Sono sempre qui per aiutarti!

Ho scoperto che esiste un sito, lexica.art sul quale si possono generare immagini che sembra utilizzi il motore di stable diffusion, ma l'aspeto finale è molto diverso, lo definirei di plastica.

Sì, esiste un sito chiamato "Lexica Art" che utilizza l'algoritmo Stable Diffusion per generare immagini, ma con una particolare variazione che gli conferisce l'aspetto "di plastica" di cui parli.

In realtà, la tecnica utilizzata su Lexica Art prende spunto dalla tecnica di "diffusione stabilizzata" di Stable Diffusion, ma prevede l'aggiunta di un ulteriore passaggio di post-processing, chiamato "style transfer", che modifica l'aspetto delle immagini generando effetti di illuminazione, colore e texture che ricordano appunto la plastica.

Lo stile transfer è una tecnica di elaborazione delle immagini basata sull'apprendimento profondo che consente di applicare lo stile di una o più immagini di riferimento a una data immagine di input. In questo modo, è possibile modificare l'aspetto dell'immagine generata in base a un determinato stile, come ad esempio l'aspetto plastico presente su Lexica Art.

Questa tecnica può essere utilizzata in combinazione con algoritmi di generazione di immagini come Stable Diffusion per creare immagini ancora più complesse e artistiche, modificando l'aspetto generale dell'immagine generata.

Spero che questa spiegazione ti sia stata utile. Se hai ulteriori domande o dubbi, non esitare a chiedere!

E di DALL-E (Nuova pagina) invece?

DALL-E è un modello di generazione di immagini creato da OpenAI che utilizza una combinazione di tecniche di deep learning, tra cui la generazione di testo-to-image (text2image) e l'elaborazione di immagini guidata dal testo (text-guided image editing).

A differenza di Stable Diffusion, che utilizza un processo di diffusione per generare immagini, DALL-E utilizza una rete neurale che prende in input una descrizione testuale e genera un'immagine corrispondente. Il modello di DALL-E è stato addestrato su un enorme set di dati di testo e immagini, in modo da apprendere le relazioni tra gli oggetti e le parole utilizzati nella descrizione.

Una delle caratteristiche più interessanti di DALL-E è la sua capacità di generare immagini altamente dettagliate e complesse a partire da descrizioni testuali relativamente semplici. Ad esempio, DALL-E può generare immagini di fantasiosi "elefanti di cioccolato" a partire da una descrizione testuale come "un elefante fatto di cioccolato".

Inoltre, DALL-E può essere utilizzato per modificare le immagini esistenti, utilizzando descrizioni testuali come input per la modifica guidata dal testo delle immagini.

In sintesi, DALL-E è un modello di generazione di immagini molto avanzato che utilizza un approccio basato sul testo per generare immagini altamente dettagliate e complesse

Quindi DALL-E avrebbe la possibilità di crere immagini di fantasia, mentre Stable Diffusion fa solo dei collage? O non ho capito nulla?

In un certo senso si potrebbe dire che DALL-E ha la capacità di creare immagini di fantasia a partire da una descrizione testuale, mentre Stable Diffusion si concentra sulla generazione di immagini a partire da immagini esistenti.

In particolare, DALL-E è stato addestrato su un vasto insieme di dati di testo e immagini per apprendere le relazioni tra gli oggetti e le parole utilizzati nella descrizione testuale. Ciò gli consente di generare immagini altamente dettagliate e complesse a partire da descrizioni testuali relative a oggetti o scene immaginarie.

Stable Diffusion, d'altra parte, utilizza un processo di diffusione per creare immagini a partire da un'immagine di input. Ciò significa che l'algoritmo è in grado di creare immagini che sono comunque basate su immagini esistenti. Tuttavia, l'uso di tecniche di post-processing come lo stile transfer può modificare l'aspetto delle immagini generando effetti artistici e di manipolazione delle immagini.

In sintesi, mentre DALL-E è stato progettato per creare immagini di fantasia a partire da descrizioni testuali, Stable Diffusion è più adatto per creare immagini artistiche a partire da immagini esistenti, che possono essere modificate e manipolate attraverso l'uso di tecniche di post-processing.

Chiarissimo

Sono felice di aver chiarito i tuoi dubbi! Se hai altre domande o curiosità, non esitare a chiedere

Veniamo un attimo ai prompt, ci sono delle metodologie per redigerli?

Sì, ci sono alcune metodologie che puoi utilizzare per redigere i prompt in modo efficace. Di seguito ti fornisco alcune suggerimenti:

- Specificità: è importante che il prompt sia abbastanza specifico da consentire al modello di generazione di immagini di comprendere esattamente cosa si sta cercando di creare. Ad esempio, invece di scrivere "crea un paesaggio", potresti specificare "crea un paesaggio di montagna con un lago e un rifugio".

- Coerenza: il prompt deve essere coerente con l'obiettivo dell'immagine che si desidera generare. Ad esempio, se si vuole generare un'immagine di un paesaggio invernale, il prompt dovrebbe includere parole chiave come "nevoso", "ghiacciato" o "freddo".

- Sintesi: il prompt dovrebbe essere il più chiaro e sintetico possibile, evitando parole superflue o frasi troppo lunghe.

- Originalità: cerca di rendere il prompt il più originale possibile, evitando frasi troppo generiche o già utilizzate molte volte. In questo modo, si stimola il modello a creare immagini uniche e originali.

- Dettagli: l'aggiunta di dettagli al prompt può aiutare il modello a comprendere meglio ciò che si vuole ottenere. Ad esempio, se si desidera generare un'immagine di un gatto, si potrebbe specificare il tipo di gatto, il colore del pelo o la posizione del gatto nella scena.

- Limiti: talvolta, può essere utile impostare dei limiti al prompt, come ad esempio specificare il tipo di sfondo o la posizione degli oggetti nella scena.

Ricorda che questi sono solo suggerimenti e che la creazione di prompt efficaci dipende in gran parte dal tuo obiettivo e dalla creatività.

Infine un punto molto controverso: il diritto di autore su queste immagini

Il diritto d'autore sulle immagini generate da modelli di generazione di immagini può essere un tema controverso e complesso. In linea di principio, se un'immagine generata da un modello di generazione di immagini contiene elementi coperti da diritto d'autore, ad esempio una foto o un'illustrazione di terze parti, potrebbero sorgere questioni relative alla proprietà intellettuale.

Inoltre, se l'immagine generata è stata creata utilizzando dati o modelli di addestramento protetti da diritto d'autore, come nel caso di DALL-E, potrebbe essere necessario ottenere il permesso dell'autore per l'utilizzo commerciale delle immagini generate.

Tuttavia, in generale, se l'immagine è stata generata a partire da una descrizione testuale o da un'immagine esistente manipolata attraverso l'uso di tecniche di post-processing, è probabile che l'immagine generata non violi il diritto d'autore, poiché l'immagine stessa è stata creata dal modello di generazione di immagini.

Tuttavia, è sempre importante verificare le leggi sui diritti d'autore applicabili nella giurisdizione in cui ci si trova e consultare un avvocato o un esperto in materia di proprietà intellettuale per ottenere consigli specifici.

Questo vuol dire che se genero una imagine con DALL-E questa risulta di proprietà di DALL-E?

In generale, l'immagine generata con DALL-E sarebbe di proprietà dell'utente che ha creato il prompt e ha utilizzato il modello di generazione di immagini per crearla, non di DALL-E. Tuttavia, come ho menzionato in precedenza, se il modello di DALL-E utilizza dati o modelli di addestramento protetti da diritto d'autore, potrebbe essere necessario ottenere il permesso dell'autore per l'utilizzo commerciale dell'immagine generata.

Inoltre, potrebbero esistere anche limitazioni all'uso delle immagini generate con DALL-E a livello di licenza d'uso e di utilizzo dei servizi online che offrono l'accesso al modello di generazione di immagini. Pertanto, è importante verificare le condizioni d'uso specifiche relative all'utilizzo di DALL-E o di qualsiasi altro servizio di generazione di immagini per capire appieno i diritti e le limitazioni legate all'uso delle immagini generate.

Diciamo quindi che se le tengo per me o al limite le pubblico sul mio sito web senza fini commerciali non dovrei avere problemi

In generale, se utilizzi DALL-E per generare immagini e le utilizzi per uso personale o non commerciale, non dovresti avere problemi. Tuttavia, se vuoi utilizzare le immagini generate per un uso commerciale, come ad esempio per la pubblicazione su un libro, su un sito web a pagamento o per la creazione di prodotti, potrebbe essere necessario ottenere il permesso dell'autore o considerare l'utilizzo di immagini di pubblico dominio o di altre risorse visive che non presentano restrizioni di copyright.

Inoltre, è sempre importante ricordare che le condizioni d'uso specifiche relative all'utilizzo di DALL-E potrebbero contenere restrizioni o limitazioni specifiche in relazione all'uso delle immagini generate, pertanto è sempre consigliabile verificare attentamente le condizioni d'uso e consultare un esperto in materia di diritto d'autore per capire appieno i diritti e le limitazioni legate all'uso delle immagini generate.

Ok

Posso esserti utile in altro modo?

Visto che siamo in argomento, posso utilizzare le tue risposte sul mio sito web personale, senza alcuno scopo di lucro, ovviamente citando la fonte?

Sì, puoi utilizzare le mie risposte sul tuo sito web personale a patto che citi la fonte, ovvero che indichi che le risposte sono state fornite da ChatGPT, un'intelligenza artificiale addestrata da OpenAI. Tuttavia, ti consiglio di considerare che le mie risposte sono state scritte in base alle conoscenze e alle informazioni di cui dispongo al momento (febbraio 2023, ndr.), pertanto potrebbero non essere sempre precise o aggiornate rispetto a eventuali cambiamenti normativi o a nuove scoperte in ambito scientifico. Ti consiglio quindi di verificare sempre le informazioni che intendi utilizzare e di assicurarti che siano accurate e aggiornate.

Naturalmente. Grazie e a presto!

Di nulla, è stato un piacere aiutarti. Se avrai altre domande o dubbi in futuro, non esitare a contattarmi. A presto!